Banque et Assurance

La transformation digitale au service de la résilience de votre SI et de la satisfaction clients

Dès la fin des années ’90, le secteur financier a fait figure de pionnier en matière de transformation digitale. Pour les banques comme pour les assurances, la nécessité d’accompagner l’évolution des attentes clients en matière de dématérialisation de la relation est en effet rapidement apparue comme un facteur de compétitivité. Cette dynamique a profondément modifié le fonctionnement de l’écosystème, notamment en matière de distribution des produits et services, tout en jouant un rôle d’accélérateur formidable pour l’innovation : nouveaux moyens de paiement, agences virtuelles, tokenisation des actifs, etc.

Pour autant, bien que le mouvement se soit donc enclenché il y a déjà un quart de siècle, force est de constater qu’il reste beaucoup à faire. De nombreux freins à l’efficacité des initiatives de digitalisation sont en effet prégnants chez la plupart des acteurs du secteur : des systèmes hérités dont certains éléments peuvent remonter aux débuts de l’informatique, l’étendue inégalée des patrimoines applicatifs, le silotage des métiers avec spécialisation des structures et utilisation d’outils dédiés, le phénomène de concentration au travers de M&A qui complexifie l’unification des SI…

De par la nature de leur activité, les banques comme les assurances entretiennent des relations souvent quotidiennes avec des clients dont le nombre peut dépasser le million d’unités. Pour gérer ces relations le plus efficacement possible et maintenir le niveau de satisfaction, elles sont amenées à créer et à manipuler des quantités de données phénoménales. La prolifération de la donnée dans ces organisations, encore accélérée par la transformation digitale, génère son lot de risques et d’opportunités. Pour maîtriser les premiers et valoriser les secondes, il s’avère essentiel de s’équiper d’outils permettant de faciliter et d’opérationnaliser la gouvernance de la donnée.

Les enjeux de l’évolution et de la digitalisation

des banques et des assurances

Pour les banques comme pour les assurances, le cœur de la promesse client repose implicitement sur la maîtrise des enjeux prudentiels, afin de pouvoir garantir de faire face à tout moment à une éventuelle nécessité de mobiliser les avoirs (retraits de fonds massifs des comptes de dépôts à vue pour les banques, sinistralité exceptionnelle pour les assurances). Rien d’étonnant donc à ce que les autorités aient mis en place des corps de règles spécifiques pour le secteur financier, et que ces derniers se soient régulièrement adaptés à un contexte de plus en plus numérique : BCBS 239 pour les banques par exemple, ou Solvency II pour les assurances.

Cependant, la digitalisation croissante crée par nature des conditions opérationnelles fluidifiées et modifie ainsi profondément le profil de risque, comme le souligne le Basel Committee on Banking Supervision dans son rapport de mai 2024 intitulé Digitalisation of finance : « While digitalisation can benefit both banks and their customers, it can also create new vulnerabilities and amplify existing risks to banks, their customers and financial stability ». Dans ce contexte de vulnérabilité accrue, la maîtrise de la donnée est naturellement identifiée comme un enjeu clé.

Face à ces risques nouveaux ou exacerbés, dont des exemples récents ont montré qu’ils sont malheureusement tout sauf théoriques (témoin par exemple la faillite brutale de Silicon Valley Bank SVB en mars 2023), le régulateur est amené à adapter et relever ses niveaux d’exigences. Si on ne peut qu’être d’accord avec le principe de ces nouvelles contraintes, matérialisées par exemple par DORA Digital Operational Resilience Act, il faut aussi reconnaître que les implications pour le secteur financier sont à la fois majeures et difficiles à satisfaire, et qu’elles imposent en tout état de cause pour chaque acteur une meilleure connaissance de son patrimoine informationnel et une capacité à automatiser l’exploitation de cette connaissance.

Une caractéristique commune entre les banques et les assurances, c’est que leurs clients leur confient des sujets d’importance primordiale : leurs finances et donc leurs moyens de subsistance, la protection des biens et des personnes qu’elles affectionnent, etc. Le niveau d’attente est donc légitimement très élevé par rapport à la manière dont ces acteurs gèrent leur activité, et toute défaillance visible en matière de conformité ou de fuite de données est immédiatement sanctionnée par un lourd déficit d’image et une perte de confiance.

Au passage, il est important de noter que cette approche défensive de la gouvernance des données n’est pas incompatible avec une approche offensive, au service de l’innovation et d’une meilleure satisfaction client. Au contraire, la connaissance des données de l’organisation permet de les mettre en relation et de les partager, de sorte à poser les conditions d’une relation client plus personnalisée et plus dynamique.

Comment améliorer le niveau

de conformité réglementaire ?

Les exigences réglementaires ne cessent d’évoluer et de se renforcer. Banques et assurances sont particulièrement exposées face à une volonté de plus de supervision clairement affichée par le régulateur. Répondre à cet enjeu constitue une nécessité non seulement pour éviter des amendes qui peuvent s’avérer colossales, mais aussi pour préserver le capital confiance des clients.

Normaliser et classifier

automatiquement les données

L’utilisation d’un outil de normalisation et classification automatique des données permet d’identifier de manière transverse l’existence de sources traitant des informations réglementées. En cas d’écart de conformité, l’outil permet également de faciliter la remédiation.

Comment faire face

au risque de fuite de données ?

La digitalisation des échanges a pour corollaire potentiel la dissémination d’informations sensibles dans des zones du SI qui n’ont pas été conçues pour les héberger. L’augmentation incontrôlée de la surface d’exposition peut résulter dans une perte de données dommageable à la compétitivité et à l’image, que ce soit en cas de cyberattaque ou de fraude interne.

Cartographier automatiquement toutes les sources de données

Grâce au catalogage automatique, il est possible de savoir instantanément où se trouvent les différentes typologies de données, avec leur niveau de criticité, afin de prendre les mesures de protection appropriées : effacement, déplacement, anonymisation… En programmant la fréquence d’exécution des scans, il est possible de gérer la cartographie en quasi-temps réelComment garantir le bon traitement et l’exploitabilité des données de référence ?

La fiabilisation des données de référence est un enjeu majeur pour améliorer la qualité des analyses et les prises de décisions stratégiques. Pour les banques et les assurances, il est également indispensable de pouvoir justifier auprès du régulateur de la traçabilité de bout en bout de certaines de ces données, lorsqu’elles font l’objet d’une déclaration obligatoire.Construire un référentiel centralisé

Une solution de catalogage associée à un système de data management (MDM) permet d’homogénéiser l’approche transverse autour des concepts clés, d’identifier la localisation des « golden data » correspondantes, et de procéder à la consolidation et au partage de ces données.

Comment s’ouvrir à l’écosystème de manière sûre et dynamique ?

Si les principes de l’open banking introduits par la PSD2 dès 2016 ont pu être initialement accueillis avec une certaine inquiétude tant ils changeaient la donne, leur application est maintenant largement répandue et a produit de premiers résultats observables en matière d’innovation. Sans revêtir le même caractère réglementaire, l’open insurance est aujourd’hui promue par de nombreux acteurs comme un levier de personnalisation de l’offre et d’amélioration de l’expérience client.Mettre en place un modèle de travail collaboratif de confiance

L’utilisation d’une solution de management des API permet de sécuriser l’ouverture des flux sur l’extérieur, notamment en termes de contrôle d’accès et de gestion des profils. Combinée avec un outil de catalogage, cette ouverture applicative peut s’accompagner de la mise à disposition de datasets collaboratifs, vecteurs d’innovation conjointe entre des détenteurs d’informations et des créateurs de services.Quelles sont les méthodes et les solutions pour répondre aux enjeux de la digitalisation des banques et des assurances ?

Comme rappelé plus haut, les systèmes d’information des banques et des assurances souffrent fréquemment, pour une partie au moins du patrimoine, d’un syndrome de vétusté qui en limite l’évolutivité et la connectabilité. Pour pallier ces inconvénients sans avoir à refondre intégralement les systèmes concernés, l’utilisation d’une approche de bus applicatif peut rendre possible à moindre impact des échanges inter-applicatifs pour décloisonner la donnée.

S’agissant des données elles-mêmes, qu’elles proviennent d’un environnement applicatif structuré ou de sources de données informelles de plus en plus répandues comme la bureautique ou les espaces de travail collaboratifs, la première étape de toute exploitation réussie consiste dans la mise en place d’une démarche de catalogage bien orchestrée. Grâce à ses fonctionnalités automatisées de découverte, de normalisation et de classification, le catalogage permet de poser un socle robuste, largement accessible et évolutif pour l’utilisation du patrimoine de données.

Enfin, un travail en continu sur la qualité de la donnée doit impérativement faire partie de toute feuille de route de transformation digitale pour les banques et les assurances. A condition d’agir au niveau des enregistrements unitaires et non des seules métadonnées, une solution de catalogage permet d’assurer la qualité en amont, dans chacune des applications. Indépendamment ou de façon conjointe, une approche de data management (MDM) peut aussi permettre des contrôles et faciliter des actions d’amélioration au niveau d’un référentiel alimenté et consommé par différentes applications.

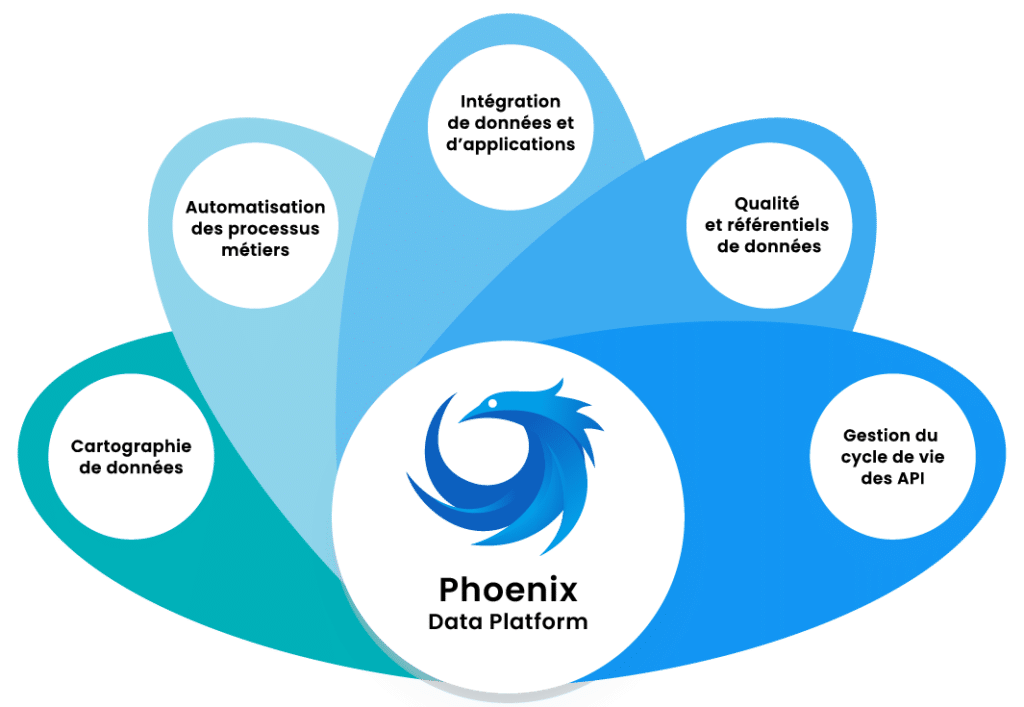

La plateforme Phoenix pour accompagner la transformation digitale des acteurs de la banque et de l’assurance

Avec sa plateforme modulaire Phoenix, Blueway dispose d’une palette de fonctionnalités larges pour accompagner les acteurs du secteur financier dans leur feuille de route digitale, en leur permettant notamment de faire face plus efficacement à plusieurs enjeux majeurs :

Disposer d’une vision holistique du patrimoine de données

exploitable et actualisée en permanence.

Augmenter le niveau de qualité

de la donnée applicative

et la maintenir dans le temps, pour améliorer la capacité décisionnelle et l’innovation.

Diffuser une culture data driven

au sein de l’organisation

en rendant les données utiles facilement accessibles et compréhensibles.

Satisfaire aux exigences réglementaires

qu'il s’agisse des traitements, de la conservation ou encore des obligations déclaratives.

Assurer une contribution effective de la donnée à la compétitivité,

que ce soit d’un point de vue défensif en contrôlant les coûts (optimisation d’architecture et d’infrastructure, limitation des risques en matière de perte de données, de fraudes, de risques d’amende, etc.) ou en générant des opportunités de revenus (fidélisation clients, ventes croisées, innovation, partenariats, etc.).

MyDataCatalogue, le module de catalogage de données de la plateforme Phoenix

Comme nous avons pu le voir précédemment, le catalogage de données peut être vu comme le socle sur lequel bâtir différents cas d’usage autour de la donnée. Encore faut-il choisir une approche de catalogage qui convient aux objectifs poursuivis, et va véritablement permettre de dérouler ces cas d’usage avec un ROI optimal.

MyDataCatalogue est commercialisé depuis 2017, et dispose donc aujourd’hui d’un retour d’expérience supérieur à la plupart des solutions, notamment dans le secteur financier. Dès avant même sa mise en marché, l’approche a été développée avec une ligne directrice forte : l’automatisation de bout en bout, depuis la data discovery jusqu’à la classification, en passant par la normalisation à base d’algorithmes propriétaires et d’IA.

L’automatisation apporte des bénéfices évidents en termes de gain de temps, que ce soit en délai comme en charge, ce qui permet des cycles de projets incomparablement plus rapides et plus légers que les approches de catalogage déclaratif. Mais ce n’est pas tout : l’automatisation permet également d’atteindre un niveau d’exhaustivité qui n’est pas envisageable autrement, notamment dans le secteur financier où les patrimoines applicatifs sont en grande partie hérités, avec des pans entiers qui sont potentiellement mal documentés et qu’aucun collaborateur actuellement en poste ne peut prétendre connaître intégralement. Dernier avantage remarquable de l’automatisation, la capacité de programmer une exécution fréquente des scans, permettant ainsi de garantir une vision du patrimoine toujours up to date.

Exemples de cas d'usage

Urbanisation du Système d’Information

Renforcer la scalabilité du Système d’Information afin de soutenir la politique de croissance externe et l’intégration de nouveaux systèmes.

Mise en œuvre de la conformité

Respecter les Bonnes Pratiques de Fabrication avec un MDM comme élément central du Système d’Information.

Consolidation des processus

Renforcer l’agilité des process pharmaceutiques tout en facilitant leur auditabilité avec un BPM connecté au Système d’Information.

Maîtrise des données partagées dans l’écosystème

Contrôler les échanges avec un écosystème de start-ups et de laboratoires, et capitaliser sur les données partagées afin de maîtriser les flux de bout en bout.

Nos derniers contenus autour de la gouvernance de données dans le secteur financier

Les questions les plus fréquentes autour de la digitalisation des banques et des assurances

L’autre élément fondamentalement différentiant de MyDataCatalogue par rapport à la plupart des solutions du marché, c’est la capacité à porter la découverte non pas seulement au niveau des métadonnées, mais également au niveau des données unitaires si cela est nécessaire. Certains des cas d’usage, notamment en matière de mise en qualité ou de détection d’écarts de conformité, ne sont tout simplement pas possibles si l’outil utilisé ne descend pas au niveau des données elles-mêmes.

Un accent particulier a également été mis dès le départ sur la présentation du catalogue en fonction des besoins de différentes catégories d’utilisateurs. En effet, selon leur profil et leur rôle dans l’entreprise, tous les collaborateurs n’auront ni le besoin ni l’autorisation d’accéder au contenu du catalogue avec le même degré de granularité. Au-delà d’une simple gestion des accès, des IU spécifiques ont été optimisées par rapport à certains cas d’usage, permettant de réduire le besoin en matière de change management.

Enfin, il faut souligner que MyDataCatalogue peut être déployé aussi bien en mode SaaS qu’en mode on premise. Notre retour d’expérience nous montre que la possibilité d’opérer le service intégralement dans sa propre infrastructure constitue une caractéristique particulièrement appréciée par nombre de banques et d’assurances !