La bonne circulation de la donnée dans le système d’information est aujourd’hui un impératif pour alimenter correctement les métiers, les applications et les processus qui forment le cœur de l’activité de l’entreprise. Face à la multitude de sources de données et la complexité croissante des SI (parc applicatif en extension, architecture hybride, multiplication des flux…), une supervision complète est indispensable. Celle-ci permet de garantir la bonne santé du SI, colonne vertébrale des échanges métier et source de qualité et d’efficacité des processus.

L’importance des flux de données au sein du Système d’Information

Les données alimentent l’ensemble de l’entreprise et ses équipes métiers : les problèmes qu’elles rencontrent durant leur acheminement et leur transformation peuvent donc rapidement se révéler critiques pour l’organisation. Ces problèmes peuvent aussi bien être dus à des faiblesses matérielles (pannes, coupure de courant…) qu’à un mauvais traitement de la donnée (existence de doublons, données incomplètes ou dégradées par les utilisateurs successifs, les transferts ou les transformations…).

La data doit non seulement circuler sans interruption entre tous ses producteurs et consommateurs (collaborateurs, applications, outils de BI, data lakes…), mais son intégrité doit aussi être assurée. S’appuyer sur des données intègres participe à la performance de l’entreprise au quotidien, ainsi qu’à la conformité de la data aux exigences du secteur.

Il est pour cela nécessaire de prendre de la hauteur sur son SI en bâtissant une vision globale des flux d’information. Disposer d’une vue 360° de la circulation des données au sein du système d’information permet d’analyser le cycle de vie de la donnée et sa qualité.

L’urbanisation et la supervision des échanges sont ainsi essentielles pour identifier les flux critiques et être informé en temps réel des dysfonctionnements existants ou potentiels. En cartographiant les flux d’informations et en industrialisant les échanges inter-applicatifs, l’organisation pourra continuer à tirer parti de ses applications – récentes ou legacy – et optimisera les échanges avec l’écosystème des partenaires.

Interopérabilité entre processus et données : le cœur de l’agilité d’une entreprise.

La supervision des flux de données directement liée au besoin d’urbanisation

Du service IT aux instances décisionnelles, la compréhension des flux de données et des besoins des processus métiers sont les clés d’un bon pilotage. L’information doit remonter dès que nécessaire, sans dégradation, vers les consommateurs qui en ont besoin. Une démarche rendue plus complexe encore par l’hybridation croissante des systèmes, qui tentent de concilier applications Cloud et on-site. Comprendre dans le détail la logique de ses flux et mieux les orchestrer est donc essentiel pour soutenir toute démarche d’urbanisation.

Plusieurs solutions apportent de la visibilité sur le trajet interne de la data.

Les diagrammes de flux de données, notamment, constituent une bonne introduction à la supervision. Les solutions liées à l’urbanisation et à l’intégration de données sont également nombreuses. Comme ce thème a déjà été abordé dans de précédentes articles (comme urbanisation du SI et architecture hybride et urbanisation du SI au sein d’une coopérative agricole) : nous nous concentrerons dans la suite de cet article sur la facette de supervision des flux.

En effet, la supervision des flux implique de déployer des fonctions spécifiques de visualisation, d’alertes et d’analyse volumétrique. On contrôle ainsi le déroulement complet des flux et les tendances de consommation de la donnée. Le pilotage opérationnel repose sur des indicateurs tels que :

- La volumétrie de la data circulant entre les applications

- La criticité des flux impliqués

- Le nombre d’applications participant aux échanges

- La disponibilité de ces applications

- Le temps de réponse des flux

Ces fonctions sont complétées par des alertes et tableaux de bord, qui contribuent à une résolution préventive des erreurs. On bénéficie alors d’un quadruple avantage :

- Synthèse des flux : la vue synthétique et en temps réel sur les flux est source de transparence et de maîtrise des flux à tout instant.

- Anticipation : la supervision fournit des outils pour prioriser les actions correctives et éviter l’aggravation des anomalies.

- Réactivité : agir vite face aux problèmes permet de limiter toute perte de données (et plus largement, financière), mais aussi d’améliorer les conditions de travail des collaborateurs métier.

- Productivité : en pilotant les flux et en corrigeant les erreurs à temps, on coordonne mieux la communication inter-applicative et on conforte la confiance des utilisateurs envers leurs données.

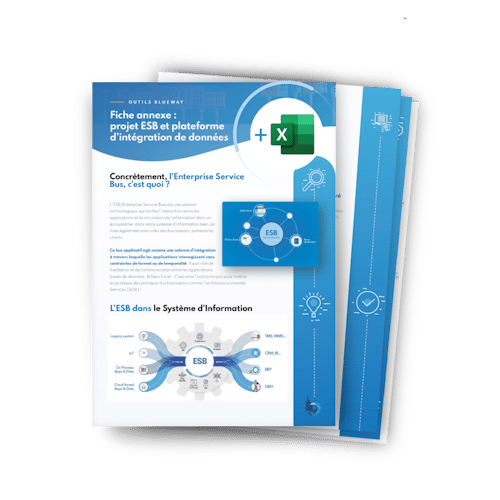

Besoin d’y voir plus clair sur votre projet d’ESB ou de plateforme d’intégration de données ?

Data Foundation, la plateforme Blueway pour une supervision unifiée des flux

Face à l’enjeu de supervision des flux, Il est important de traiter toutes les dimensions de la donnée. C’est pourquoi la solution Data Foundation de Blueway vous permet de réaliser toutes les actions nécessaires sur vos données au sein d’une plateforme unique et fournit également des outils de supervision grâce à une console de pilotage native.

Data Foundation pilote à la fois les règles de transformation et de consommation de la donnée, la maîtrise du cycle de vie des données, leur mise en qualité, le monitoring des traitements et l’analyse des dépendances et impacts :

- Collecte des données : vous rapatriez toutes les données de votre SI (On Premise, Cloud privé et public…), quelles que soient les possibilités disponibles (XML, webservices, FTP, API REST…).

- Consommation et transformation : transformation, transcodification, enrichissement aussi bien que règles de gestion : vous pouvez opérer tous les traitements nécessaires au sein d’un éditeur graphique et Low Code.

- Déversement et exposition : la donnée peut être exposée en toute sécurité au sein du SI dans une logique SOA ou déversée dans les applications cibles définies. La communication, synchrone ou asynchrone, est assurée entre toutes les entités du SI.

- Vue d’ensemble et réactivité : quels sont les traitements en cours ? Ceux en échec ? Les causes ? La supervision complète des flux s’accompagne d’alertes et d’informations précieuses pour localiser rapidement les dysfonctionnements.

Avec les fonctionnalités de supervision de la donnée de Data Foundation, Blueway a souhaité concilier temps réel et vue à 360°. Le système de déclencheurs de la plateforme permet une mise à jour constante et proactive de vos flux en fonction des événements, tout en adoptant une stratégie à long terme pour l’évolution de votre SI.

En combinant Data Foundation avec les modules complémentaires d’orchestration des processus (BPM) et de centralisation de la data (MDM), Blueway permet une maîtrise complète de la circulation des données sous ses facettes métiers et techniques !

Échangez sur l’interopérabilité de votre SI avec un expert Blueway !