Les directions IT et métiers font actuellement face à une double pression : prouver la fiabilité des chiffres qui pilotent l’activité et démontrer, à tout moment, la conformité des traitements. Dans un paysage réglementaire qui s’est densifié cette année, avec l’entrée en application de DORA le 17 janvier 2025, et les obligations progressives de l’EU AI Act depuis février et août 2025, la traçabilité des données est devenue l’ossature d’une « bonne » gouvernance. Pour autant, de très nombreux DSI se demandent encore comment mettre en place de manière efficace cette traçabilité des données ?

A noter que cet article fait partie d’une série de 4 articles, dans lesquels nous abordons les quatre grands types de processus de gestion des données : collecte, analyse, validation et traçabilité.

Data Observabilité et Data Lifecycle Management au service de la traçabilité

La traçabilité vit à l’intersection de la visibilité en continu sur l’état et le parcours de la donnée, et de la maîtrise de son cycle de vie de bout en bout.

C’est précisément ce que relient la Data Observabilité et le Data Lifecycle Management.

L’observabilité collecte et corrèle des signaux d’exécution, des métadonnées, du lineage et des profils qualité pour éclairer, en temps réel, l’histoire d’un indicateur ou d’un flux. Elle permet de comprendre où, comment et pourquoi une donnée a dérivé, d’objectiver une reprise en définissant des objectifs de service sur la donnée, et de transformer un incident potentiel en décision rapide et expliquée. Le DLM, lui, fixe le cadre. Il balise la création, le stockage, l’usage, le partage, l’archivage et la suppression, avec des règles de conservation, des habilitations et des preuves de purge.

Ensemble, ces deux disciplines transforment la traçabilité en capacité opérationnelle et opposable, en rendant explicites les preuves à chaque étape du parcours de la donnée.

- Concrètement, l’observabilité utile rassemble l’état d’exécution des pipelines, les distributions statistiques des tables, la cartographie dynamique des dépendances et l’historique des événements, puis la rend exploitable par les équipes.

- Dans le même temps, le DLM garantit que chaque étape laisse des traces fiables, que la donnée est disponible pour les ayants droit, protégée par des règles d’accès et supprimée dans les temps lorsque la finalité s’éteint.

« Lorsque l’on clique sur un KPI en réunion, on doit pouvoir dérouler son lineage (origine), afficher la dernière distribution des valeurs, identifier un changement de schéma ou un pic de volume et comprendre l’impact potentiel en aval. »

Les nouvelles exigences réglementaires et sectorielles

IA Act et DORA

Côté réglementation, l’entrée en vigueur de l’IA Act impose désormais aux organisations une exigence très concrète en matière de traçabilité des données d’entraînement, des versions de modèles, des évaluations de performance et des incidents.

Sans cette chaîne de preuves, l’auditabilité et la transparence restent théoriques…

Dans la finance, DORA impose un cadre européen de résilience opérationnelle numérique. La logique du texte est claire : relier la gestion des incidents TIC à une capacité de démonstration structurée, où l’on sait reconstituer la portée d’un incident, ses causes probables et les impacts métiers.

Sans traçabilité exploitable reliant événements techniques, flux de données, dépendances inter-applications et reporting, l’exigence de remontée d’incident se heurte à une boîte noire. Avec une traçabilité bien conçue, le reporting devient un geste maîtrisé, étayé par des preuves.

BCBS

Toujours dans le secteur bancaire, les quatorze principes de BCBS 239 sur l’agrégation des données de risque et le reporting restent la référence. Ils exigent gouvernance, capacités d’agrégation exactes et complètes, adaptabilité et auditabilité, en particulier en période de stress.

En pratique, cela signifie que toute mesure de risque doit être rattachable à ses sources et transformations, que les règles d’agrégation soient documentées et versionnées, et que la chaîne de calcul soit reconstituable à la demande.

Cette doctrine irrigue les attentes des superviseurs européens et appelle une industrialisation de la traçabilité au-delà des bricolages manuels.

RGPD

Enfin, le RGPD demeure un socle constant avec son principe d’accountability.

Respecter ses principes ne suffit pas, il faut pouvoir en apporter la preuve à tout moment. Journaux d’accès, registres de partage, résultats de contrôles qualité, politiques de conservation et preuves de purge forment l’armature documentaire qui rend la conformité opposable. Et c’est précisément cette armature que la traçabilité doit produire, sans friction excessive pour les équipes.

Faire converger métiers et IT autour d’un socle commun

La traçabilité devient utile quand elle parle deux langues à la fois.

- Côté métiers, elle doit répondre à des questions simples et décisives : pourquoi ce chiffre a-t-il changé, quelles décisions faut-il corriger, quelle est l’incidence en aval si l’on ajuste une règle de gestion…

- Côté IT, elle doit garantir une exécution robuste et observable : pouvoir relier une panne à un composant, rejouer un traitement sans effet de bord, sécuriser les échanges et maîtriser les versions de schémas.

La réussite tient à la création d’un langage commun, où définitions, règles et indicateurs de qualité sont partagés, et où les écrans rendent le lineage lisible pour un non-technicien, avec une documentation générée automatiquement lors de chaque changement applicatif ou data.

C’est cette expérience qui transforme la traçabilité d’une charge administrative en réflexe de conception, au moment même où l’on construit flux, référentiels et processus. Vous devez commencer par les quelques flux qui alimentent l’essentiel du pilotage, démontrer vite la valeur et étendre par itérations, tout en instrumentant la collecte de métriques, l’historisation et la documentation à la source.

« L’objectif n’est pas seulement de « voir » mais d’expliquer et d’agir, ce qui demande un outillage compréhensible par les métiers et suffisamment robuste pour l’IT. »

Cette convergence suppose aussi de déjouer une tentation fréquente, celle de louer la traçabilité à une seule brique en fin de chaîne. La preuve utile se construit à la source, dans chaque connecteur, chaque transformation et chaque étape de workflow, plutôt qu’uniquement dans une console distante. Elle suppose que la sécurité et le cycle de vie soient nativement intégrés au même fil que les transformations et la supervision, pour éviter les fractures entre équipes et pour que les mêmes événements nourrissent à la fois le pilotage opérationnel, le contrôle interne et la conformité. C’est une transformation culturelle autant que technique, et elle s’appuie sur des rôles clairs (notamment les Data Owners et les Data Stewards qui orchestrent la qualité), la documentation et l’utilité métier de la donnée.

Comprendre la traçabilité en pratique avec un modèle opérationnel

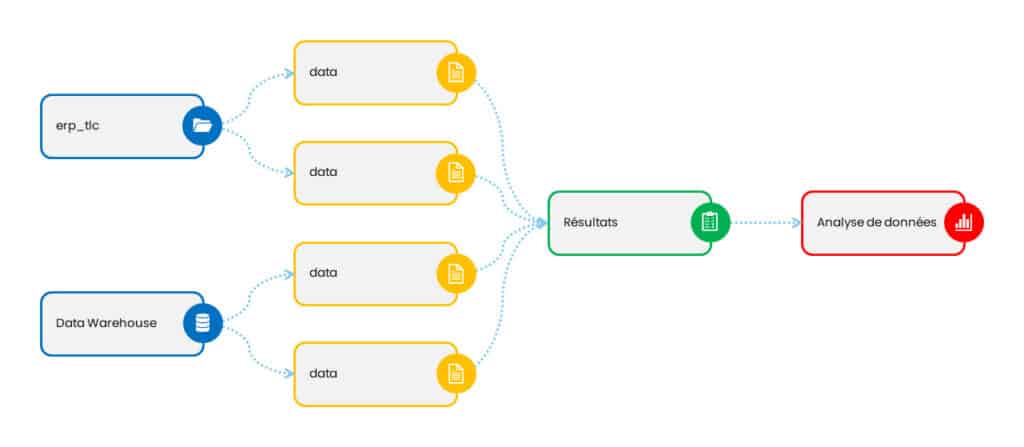

Suivons un fil rouge.

Une donnée client B2B naît dans un formulaire ou arrive via un flux amont. Elle porte son contexte : origine, base légale si nécessaire, responsable de la collecte. Les premiers contrôles valident formats, cohérences et doublons avant alimentation du référentiel maître.

Chaque enrichissement est ensuite une transformation traçable : règle identifiée, colonnes concernées, source de vérité, date d’effet, version…

Lorsqu’elle alimente un tableau de bord, un moteur d’alertes ou un modèle d’IA, le lineage relie l’objet final aux attributs d’origine. Si l’observabilité détecte une dérive, l’investigation remonte la chaîne, isole un connecteur défaillant ou une règle devenue trop stricte, évalue l’impact, orchestre la correction et enregistre la remédiation.

Cette capacité à « raconter » la vie de la donnée fait la différence. Elle peut transformer un incident en diagnostic, un contrôle en démonstration ou encore une discussion interne en décision informée.

Les 4 questions fondatrices à pouvoir éclairer à tout moment

- D’où vient la donnée ?

- Qu’a-t-on fait dessus et selon quelles règles ?

- Qui y a eu accès et quand ?

- Quel impact en aval si l’on corrige ou rejoue ?

La traçabilité n’est durable que si elle est native, continue et compréhensible

Chez Blueway, nous sommes convaincus que la traçabilité n’est durable que si elle est native, continue et compréhensible.

C’est d’ailleurs sur ce principe qu’est bâtie notre plateforme Phoenix, où le Data Catalog (MyDataCatalogue) cartographie et contextualise vos données pour les rendre trouvables et exploitées en confiance, première brique d’une traçabilité lisible par les métiers. Le MDM consolide une source de vérité versionnée et qualifiée qui documente les changements critiques. Et l’ESB transporte et transforme les flux en traçant chaque étape d’exécution pour un lineage opposable.

Ensemble, ces briques, au sein d’une architecture robuste, facilitent la collaboration métiers IT et répondent aux exigences de conformité.

Article mis à jour le 07/10/2025

Echangez sur vos problématiques de qualité de données avec un expert Blueway !